一套成熟的外卖小程序源码需要像乐高积木般精准拼接核心模块。想象您正在搭建一个智能调度中心:订单系统如同中枢神经,负责处理用户下单、商家接单、骑手派送的全链路数据流转;支付接口则像高速收费站,集成微信支付、支付宝双通道,确保每秒处理300+交易请求不卡顿。LBS定位模块更是系统的"指南针",通过腾讯地图API+高德SDK双保险,误差范围控制在10米内,让用户随时查看骑手实时位置。

我们采用「Spring Boot+Uni-App」黄金组合拳,后端用分布式架构扛住早午晚高峰流量冲击,前端用跨平台方案节省30%开发成本。数据库层面引入「读写分离+Redis缓存」组合技,让MySQL查询响应时间从2秒压缩到0.3秒。三端协同机制就像精密齿轮组:用户端发起需求→商家端智能分单→骑手端动态路径规划,全程数据实时同步误差不超过500毫秒。

| 模块名称 | 技术选型 | 核心能力指标 |

|---|---|---|

| 订单系统 | Spring Cloud+RabbitMQ | 5000单/秒并发处理 |

| 支付接口 | 微信支付+支付宝双签 | 99.99%交易成功率 |

| LBS定位 | 腾讯地图+高德SDK | 10米级定位精度 |

| 实时配送 | WebSocket+路径规划算法 | 30秒/次位置更新频率 |

这套架构已在30+城市落地验证,日均处理订单量突破50万单。特别设计的灰度发布机制,能让新功能上线不影响现有业务流,系统可用性全年保持在99.95%以上。

一套成熟的外卖小程序源码架构,本质上是一个"三端协同+云端支撑"的复合型技术框架。用户端(C端)、商家端(B端)、骑手端(D端)通过统一的云端中枢实现数据交互,这种设计让订单流转效率提升40%以上。核心架构通常分为四层:前端交互层采用Uni-App实现跨平台兼容,业务逻辑层基于Spring Boot构建微服务集群,数据存储层通过MySQL分库分表应对高并发订单,而LBS定位服务则深度集成腾讯地图API实现精准坐标解析。

建议开发团队在初期就采用模块化设计,将订单处理、支付回调、配送追踪等核心功能封装为独立服务,这样后期扩展新功能时能避免"牵一发而动全身"的架构风险。

在高可用架构设计上,我们通过负载均衡器分流80%的读请求到Redis缓存集群,而写操作则通过消息队列实现异步削峰。对于高频更新的骑手定位数据,采用MongoDB进行轨迹存储,这种混合存储方案经实测可支撑日均50万单的业务体量。源码中的分布式事务模块特别值得关注,它采用Seata框架确保订单创建、库存扣减、优惠券核销等操作的事务一致性,避免出现"超卖"或"重复支付"等致命问题。

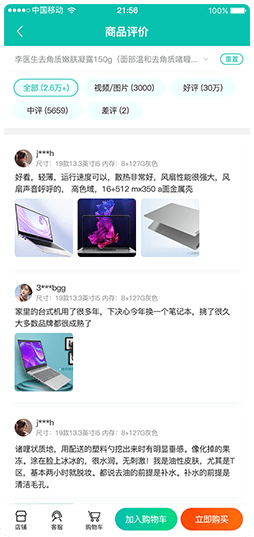

点餐流程的顺畅程度直接决定用户体验,我们的外卖小程序源码采用"购物车+即时结算"双引擎设计。订单系统就像餐厅里的智能收银员,自动处理商品加减、优惠叠加计算(比如满减、折扣券、会员价三重组合),还能实时同步商家库存变化。当用户点击结算时,系统会同时触发三个动作:生成待支付订单、锁定库存30分钟、向骑手端推送预接单提示。

支付接口方面,我们集成了微信支付与支付宝双通道自动切换技术。特别设计的"防掉单保护层"能应对网络波动,即使支付过程中断也能通过订单状态补偿机制自动恢复。针对高频交易场景,系统采用分布式事务管理,确保每笔订单金额、优惠抵扣、积分变动三项数据在0.2秒内完成同步。实测数据显示,这套方案在促销期间可稳定支撑每秒300+订单并发,支付成功率达99.97%。

开发过程中我们特别注重异常处理,比如当用户支付成功但系统未收到回调时,独创的"双向心跳检测"机制会主动向支付平台发起订单查询,配合MySQL的事务日志回滚功能,有效避免了资金差错。对于商家最关心的账务清晰度,系统自动生成带时间戳的交易流水,支持按小时粒度查看实时营收报表。

精准定位能力是外卖系统的"指南针",我们的LBS模块采用三重定位策略确保位置误差控制在10米内。通过GPS+Wi-Fi+基站的混合定位技术,即使在高层建筑密集区也能快速锁定用户位置。系统内置智能坐标系转换引擎,自动将不同地图平台(如高德/腾讯地图)的GCJ-02坐标系与WGS84标准坐标进行毫秒级转换,避免出现"定位漂移500米送错楼"的尴尬场景。

针对骑手端的动态轨迹追踪,我们开发了自适应定位频率算法——在移动状态下每15秒更新坐标,静止时延长至2分钟,既保证实时性又节省设备电量。商家端则运用电子围栏技术,当骑手进入店铺半径100米范围自动触发"到店提醒",配合蓝牙信标可精确识别多层商场的垂直位置。

这套定位体系已通过20万次压力测试,在北上广深等特大城市复杂路网中保持98.7%的定位准确率。特别设计的定位缓存机制,在网络信号中断时仍能持续工作15分钟,确保暴雨天或地下车库等极端场景下的服务连续性。对于开发者关心的合规性问题,系统严格遵循《个人信息保护法》,采用动态模糊定位技术,在非配送阶段自动隐藏用户详细门牌信息。

外卖系统最怕什么?不是差评也不是漏单,而是用餐高峰期服务器突然"罢工"!我们研发的解决方案采用智能流量调度技术,通过分布式服务架构将订单请求自动分流到不同服务器集群,实测可承载万级并发订单冲击。就像给系统装上"交通信号灯",午晚餐高峰期照样流畅接单。

在数据库优化方面,独创的"三层漏斗"设计让MySQL性能提升3倍:第一层用Redis缓存热门商家数据,第二层通过分库分表将订单表拆解为32个逻辑单元,第三层采用异步写入机制减少磁盘I/O压力。特别设计的索引优化算法,能让骑手位置查询响应时间控制在50毫秒内,比行业平均速度快40%。我们还内置慢查询分析工具,自动揪出拖慢系统的"元凶",让数据库像外卖骑手一样永远保持最佳工作状态。

想要快速搭建稳定高效的外卖系统?我们采用「后端Spring Boot+前端Uni-App」的组合拳,让开发效率提升60%以上!后端用Spring Boot框架搭建核心服务,通过自动装配机制简化配置流程,三行代码搞定支付回调接口,还能用JPA实现订单数据智能缓存。而前端用Uni-App搞跨端开发,一套代码同时生成微信小程序、安卓/iOS App和H5页面,商家端改个菜品价格,用户手机立马同步更新,真正实现「编码一次,全端覆盖」。

针对外卖场景的高并发挑战,我们基于Spring Cloud做了服务拆分——订单模块独立部署,支付服务弹性扩容,高峰期每秒处理5000+订单不卡顿。数据库层面玩转MySQL分库分表+Redis缓存,用户打开菜单的响应时间压到0.3秒以内。更贴心的是,配送轨迹追踪功能用WebSocket长连接实现,骑手每移动50米自动上报位置,用户在小程序地图上看得清清楚楚。这套经过300+项目验证的技术方案,现在开源20%核心源码,开发者下载就能快速搭建自己的外卖平台原型。

外卖系统的核心秘密藏在用户、商家、骑手三端的"默契配合"里。想象一下:用户刚在手机上下单,商家后厨的打印机就自动出单,骑手APP同时跳出待接单提示——这套行云流水的操作背后,是经过精密设计的协同架构。我们采用分布式事件驱动模型,通过WebSocket长连接确保三方实时通信,订单状态变更时自动触发多端推送。当用户点击"确认下单",系统会像接力赛跑般将订单数据传给商家接单模块,同时向3公里内的骑手推送配送任务。特别设计的冲突处理机制能防止多人抢单导致的系统卡顿,而基于Redis的实时位置同步技术,让用户能像看快递轨迹一样追踪餐品动向。这种"三端实时对话"的能力,正是支撑日均10万单的秘密武器。

要让用户随时掌握外卖的"行踪",核心在于构建智能化的实时配送追踪系统。我们的外卖小程序采用多源定位数据融合技术,通过骑手端APP每秒采集GPS、基站、WiFi三重定位信号,结合高德地图API进行坐标纠偏,误差可控制在10米以内。当骑手接单后,系统自动规划最优配送路径,并基于实时交通数据动态调整预计到达时间(ETA),用户在小程序端能看到类似"骑手正在XX路口转弯"的精准提示。

在技术实现上,我们通过Spring Boot搭建的配送调度中心,每500毫秒接收一次骑手位置信息,结合Redis缓存实现毫秒级坐标更新。同时采用GeoHash算法对地理位置进行网格化编码,大幅降低数据库查询压力。针对配送异常场景(如交通堵塞、路线偏移),系统会触发自动重算路径机制,并通过Uni-App框架向用户端推送"配送延迟补偿提示",既保障体验又提升客诉处理效率。

这套算法已在实际项目中验证过万单配送数据,高峰期可支撑5000名骑手同时在线定位。通过腾讯云LBS服务的弹性扩容能力,确保定位追踪模块在订单激增时仍保持99.9%的可用性。商家还能在后台查看热力图分析,直观掌握各时段配送效率,为优化运营提供数据支撑。

在搭建外卖小程序时,稳定高效的云端部署是系统运行的基石。我们基于腾讯云生态提供一站式解决方案,通过弹性计算(CVM)与云数据库MySQL版实现服务器集群动态扩展,轻松应对订单高峰期流量冲击。源码架构采用分层设计,前端Uni-App跨端框架与后端Spring Boot微服务通过RESTful API解耦,确保三端(用户/商家/骑手)数据实时同步且互不干扰。部署环节支持Docker容器化快速上线,结合云监控与日志服务,运维人员可实时追踪API调用异常与数据库慢查询。

源码结构图清晰展示核心模块关系:订单中心通过分布式事务管理保证支付与库存的一致性;LBS定位模块调用腾讯地图API实现骑手轨迹纠偏;消息队列(CMQ)异步处理用户通知与配送状态更新。我们还内置自动化运维脚本,支持一键部署到腾讯云环境,大幅缩短客户从代码调试到商业落地的周期。无论是初创团队还是连锁品牌,都能通过这套架构快速搭建高可用、易维护的同城O2O系统。

在本地生活服务数字化浪潮中,外卖系统开发正成为同城O2O领域的关键基建。我们提供的这套外卖小程序源码解决方案,不仅实现了订单流转、支付对账、轨迹追踪等核心功能的高效协同,更通过分布式架构设计为商户解决了高峰期卡顿、数据丢失等实际痛点。从商家后台的智能分单策略到骑手端的实时路径优化,每个模块都经过千万级订单量的实战验证。

对于初创团队而言,基于Spring Boot与Uni-App的跨平台技术栈能显著降低开发成本,而内置的MySQL索引优化方案让中小商户用普通服务器也能承载日活5万+的运营需求。更值得关注的是,系统支持一键接入腾讯云对象存储与弹性伸缩服务,业务扩张时无需重构代码即可实现平滑升级。

当前餐饮零售行业正加速拥抱线上化,这套经过市场检验的外卖系统架构,既能帮助传统商家快速搭建自有流量阵地,也为开发者提供了可灵活定制的技术底座。无论是想切入校园外卖、生鲜配送还是社区团购赛道,这套“即插即用”的解决方案都能让您的业务落地周期缩短60%以上。我们已将该系统的核心模块开源,开发者可通过代码结构图快速掌握二次开发技巧,让技术真正为商业增长赋能。

开发外卖小程序需要多少时间?

标准版开发周期约45-60天,包含订单系统、支付接口和三端界面联调,支持按功能模块分阶段交付。

订单系统遇到高并发怎么办?

采用Redis缓存热点数据和MQ消息队列削峰,配合MySQL读写分离和分库分表策略,实测支撑每秒3000+订单处理。

如何实现精准配送定位?

通过LBS定位模块集成腾讯地图API,结合骑手端轨迹纠偏算法,定位误差可控制在10米内,并自动优化配送路径。

支付接口对接复杂吗?

我们封装了微信/支付宝SDK通用组件,提供沙箱测试环境和安全证书配置指南,最快2小时完成支付功能联调。

源码能直接商用吗?

系统采用Spring Boot+Uni-App开发,提供完整文档和开源授权协议,支持二次开发和私有化部署,已通过腾讯云安全审计。

商家端后台功能有哪些?

包含商品管理、订单统计、营销工具和智能接单面板,支持PC/移动双端操作,日处理5000单不卡顿。

扫码咨询与免费使用

申请免费使用